راهنمای جامع آنالیز لاگ فایل: دیدن سایت از نگاه واقعی گوگلبات

برای «سارا»، مدیر بازاریابی فنی، گزارشهای سرچ کنسول ابزارهای ارزشمندی هستند، اما یک واقعیت انکارناپذیر وجود دارد: این دادهها فیلترشده، نمونهبرداری (Sampled) شده و اغلب با تأخیر ارائه میشوند. اگر میخواهید بدانید گوگلبات *دقیقاً* در هر میلیثانیه در سایت شما چه میکند، تنها یک منبع حقیقت وجود دارد: لاگهای سرور. تسلط بر آنالیز لاگ فایل (Log File Analysis) پیشرفتهترین سطح سئو فنی و بخشی حیاتی از استراتژی بهینهسازی خزش و ایندکس است.

آنچه در این مقاله میخوانید

- راهنمای جامع آنالیز لاگ فایل: دیدن سایت از نگاه واقعی گوگلبات

- آنالیز لاگ فایل (Log File Analysis) چیست؟

- چرا آنالیز لاگ فایل حیاتی است؟ (شکاف دادههای GSC)

- آناتومی یک خط لاگ (Log Entry)

- چگونه به لاگهای سرور دسترسی پیدا کنیم؟

- فرآیند گام به گام آنالیز لاگ فایل (Workflow)

- استفاده از ابزار آنالیز لاگ فایل (مانند Screaming Frog)

- چه چیزهایی را باید جستجو کرد؟ (بینشهای کلیدی آنالیز لاگ فایل)

- ۱. بهینه سازی بودجه خزش (Crawl Budget)

- ۲. پیدا کردن خطاهای خزش (Crawl Errors)

- ۳. تحلیل رفتار گوگل بات (Bot Behavior)

- نتیجهگیری: از دادههای خام به استراتژی فنی برنده

در حالی که ابزارهایی مانند سرچ کنسول به شما میگویند گوگل *چه چیزی را گزارش میدهد*، آنالیز لاگ فایل به شما نشان میدهد گوگل *چه کاری انجام میدهد*. این راهنما به شما میآموزد که چگونه این دادههای خام و ۱۰۰٪ دقیق را برای بهینه سازی بودجه خزش با لاگ و کشف مشکلات پنهان، تحلیل کنید.

آنالیز لاگ فایل (Log File Analysis) چیست؟

آنالیز لاگ سرور فرآیند بررسی فایلهای متنی خامی است که توسط سرور وب شما ایجاد میشوند. این فایلها (Log Files) هر «درخواست» (Hit) که به سرور ارسال میشود را ثبت میکنند. این درخواستها میتوانند از طرف یک کاربر واقعی (از طریق مرورگر) یا یک ربات (مانند Googlebot) باشند.

هر بار که Googlebot صفحهای، یک فایل CSS، یک تصویر یا یک قطعه کد جاوا اسکریپت را درخواست میکند، یک خط در لاگ فایل شما ثبت میشود. آنالیز لاگ فایل یعنی استخراج این خطوط، فیلتر کردن آنها برای شناسایی رباتهای موتور جستجو، و درک عمیق تحلیل رفتار گوگل بات.

چرا آنالیز لاگ فایل حیاتی است؟ (شکاف دادههای GSC)

بسیاری میپرسند: «چرا به آنالیز لاگ فایل نیاز دارم وقتی گزارش Crawl Stats در سرچ کنسول وجود دارد؟» پاسخ در تفاوت «دادههای گزارششده» و «دادههای خام» نهفته است.

- دادههای سرچ کنسول (GSC): این دادهها *نمونهبرداری* شده و *تجمیعشده* هستند. گوگل انتخاب میکند که چه چیزی را و چگونه به شما نشان دهد. این گزارش برای خطاهای Coverage سرچ کنسول عالی است، اما کامل نیست.

- دادههای آنالیز لاگ فایل: این دادهها ۱۰۰٪ کامل، خام و فیلترنشده هستند. شما *تمام* درخواستهای Googlebot را، از جمله خزش در URLهای پارامتری، صفحات ریدایرکت شده، و خطاهایی که GSC هرگز گزارش نمیدهد، میبینید.

نکته فنی برای سارا: سرچ کنسول به شما میگوید گوگل *تصمیم گرفته* چه چیزی را ایندکس کند. آنالیز لاگ فایل به شما میگوید گوگل *تلاش کرده* چه چیزهایی را بخزد. این به شما امکان میدهد تا قبل از اینکه مشکلی در GSC ظاهر شود، آن را شناسایی کنید.

آناتومی یک خط لاگ (Log Entry)

برای انجام آنالیز لاگ فایل، ابتدا باید یک خط لاگ را رمزگشایی کنید. اگرچه فرمتها متفاوت است (مانند Apache Combined یا Nginx)، یک ورودی معمولی چیزی شبیه به این است:

66.249.79.12 - - [08/Nov/2025:05:30:01 +0100] "GET /technical-seo/page-speed/ HTTP/1.1" 200 45821 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

بیایید این را تجزیه کنیم:

- IP Address (

66.249.79.12): آدرس IP که درخواست را ارسال کرده است. - Timestamp (

[08/Nov/2025:...]): تاریخ و زمان دقیق درخواست. - Request Method (

"GET /page-speed/ HTTP/1.1"): متد (GET)، URL درخواستی (/page-speed/) و پروتکل. - Status Code (

200): کد وضعیت پاسخ سرور (مثلاً 200=OK، 404=Not Found، 500=Server Error). - User-Agent (

"Mozilla/5.0...Googlebot/2.1..."): مهمترین بخش برای آنالیز لاگ فایل سئو. این رشته، هویت ربات را مشخص میکند.

تأیید هویت Googlebot (جلوگیری از Botهای جعلی)

هر کسی میتواند User-Agent خود را جعل کند. برای تحلیل رفتار گوگل بات به صورت دقیق، باید مطمئن شوید که با Googlebot واقعی سروکار دارید. آنالیز لاگ فایل حرفهای شامل تأیید IP از طریق (Reverse DNS lookup) است تا اطمینان حاصل شود که IP به دامنهای مانند googlebot.com تعلق دارد. همیشه IPهای خود را با لیست رسمی User-agentها و IPهای گوگل مقایسه کنید.

چگونه به لاگهای سرور دسترسی پیدا کنیم؟

این اولین مانع در آنالیز لاگ فایل است. لاگها مستقیماً در سرور شما ذخیره میشوند. روشهای دسترسی عبارتند از:

- از طریق cPanel یا Plesk: بسیاری از هاستهای اشتراکی گزینهای به نام “Raw Access Logs” یا “Logs” در کنترل پنل خود دارند.

- از طریق FTP یا SFTP: لاگها معمولاً در دایرکتوری

/logs/یا/var/log/در ریشه سرور شما قرار دارند. - از طریق SSH (خط فرمان): این روش پیشرفتهتری برای دسترسی مستقیم و حتی فیلتر کردن لاگها قبل از دانلود است.

- درخواست از میزبان (Host): اگر هاست مدیریتشده (Managed Hosting) دارید، ممکن است لازم باشد از تیم پشتیبانی بخواهید که لاگهای مربوط به بازه زمانی مشخصی را برای شما ارسال کنند.

چالش اصلی: حجم. برای یک سایت بزرگ، فایلهای لاگ میتوانند به سرعت به چندین گیگابایت برسند. باز کردن آنها با Excel غیرممکن است و اینجاست که به یک ابزار آنالیز لاگ فایل اختصاصی نیاز پیدا میکنیم.

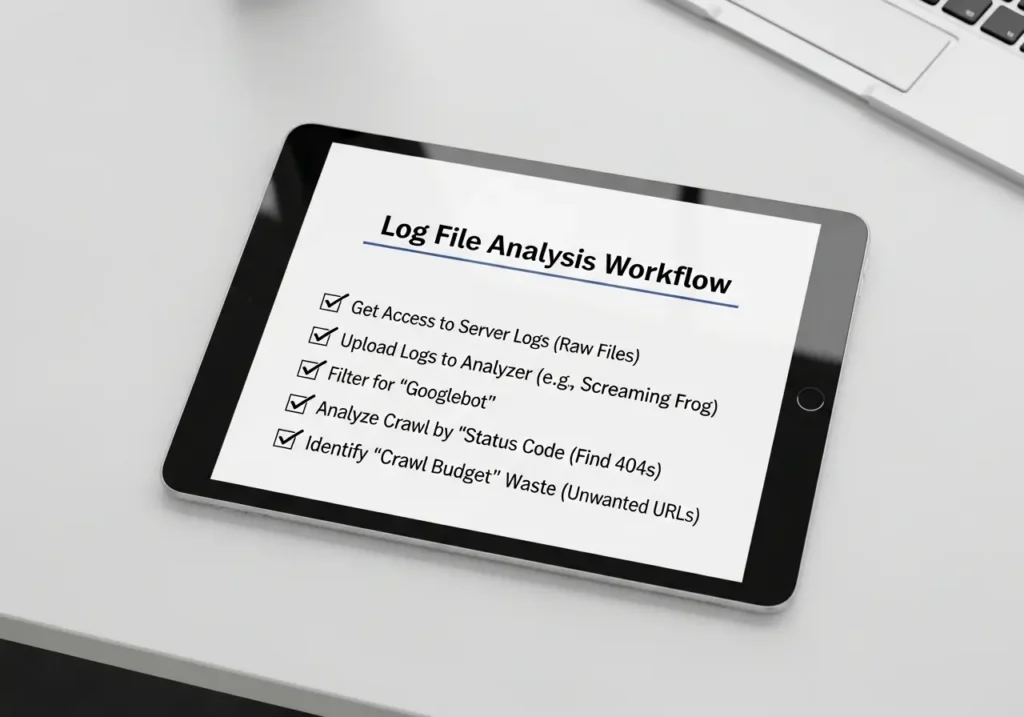

فرآیند گام به گام آنالیز لاگ فایل (Workflow)

آنالیز لاگ فایل به صورت مؤثر، یک فرآیند سیستماتیک است. صرفاً نگاه کردن به دادههای خام بیفایده است. شما به یک ورکفلو نیاز دارید.

- جمعآوری (Collect): لاگهای خود را برای یک دوره زمانی مشخص (مثلاً حداقل ۷ روز برای دادههای قابل اعتماد، یا ۳۰ روز برای الگوهای بهتر) دانلود کنید.

- پاکسازی (Clean): لاگها پر از نویز هستند (رباتهای اسپم، بازدیدهای کاربران عادی، IP خودتان). شما باید اینها را فیلتر کنید تا فقط رباتهای موتور جستجوی معتبر (Googlebot, Bingbot) باقی بمانند.

- تجزیه (Parse): فایل لاگ خام باید به یک فرمت قابل خواندن (مانند CSV یا پایگاه داده) تبدیل شود.

- ادغام (Merge): این گام حرفهای آنالیز لاگ فایل است. شما دادههای لاگ خود را با دادههای خزش (Crawl Data) از ابزاری مانند Screaming Frog ادغام میکنید. این کار به شما امکان میدهد ببینید Googlebot چند بار یک صفحه با “Depth” (عمق) ۵ یا یک صفحه “Orphan” (یتیم) را خزیده است.

استفاده از ابزار آنالیز لاگ فایل (مانند Screaming Frog)

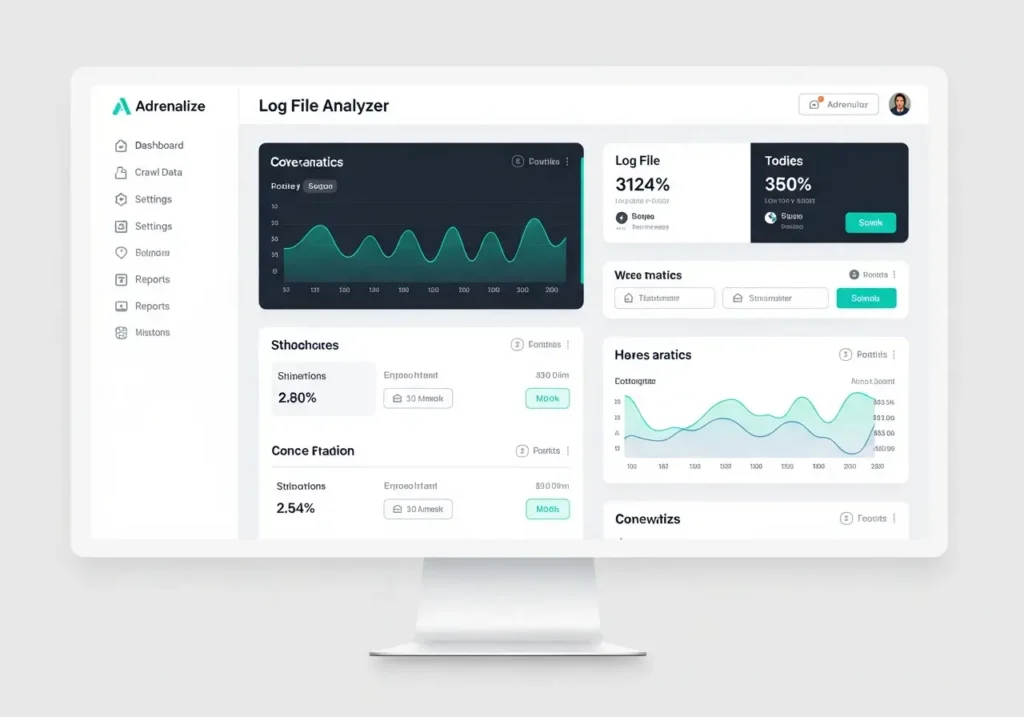

انجام مراحل بالا به صورت دستی تقریباً غیرممکن است. شما به یک ابزار آنالیز لاگ فایل اختصاصی نیاز دارید. محبوبترین و قدرتمندترین ابزار در این زمینه، Screaming Frog Log File Analyser است.

این ابزار به طور خاص برای سئو طراحی شده است. شما فایلهای لاگ خام خود را به آن میدهید و:

- به طور خودکار User-agentها را شناسایی و فیلتر میکند.

- IPها را برای تأیید هویت Googlebot بررسی میکند.

- دادهها را در داشبوردهای بصری نمایش میدهد.

همانطور که در داشبورد دیده میشود، این ابزار بلافاصله کدهای وضعیت، URLهای پربازدید توسط ربات، و فرکانس خزش را دستهبندی میکند و آنالیز لاگ سرور را از یک کار غیرممکن به یک تحلیل استراتژیک تبدیل میکند.

چه چیزهایی را باید جستجو کرد؟ (بینشهای کلیدی آنالیز لاگ فایل)

شما لاگها را دارید و ابزار را هم دارید. اکنون، به دنبال چه چیزی بگردید؟

۱. بهینه سازی بودجه خزش (Crawl Budget)

این مهمترین دلیل برای آنالیز لاگ فایل است. شما میخواهید بدانید آیا Googlebot در حال هدر دادن بودجه خزش (Crawl Budget) ارزشمند شما است یا خیر.

- URLهای پارامتری: آیا گوگلبات در حال خزش

?color=blueیا?sort=priceاست؟ (اینها باید در robots.txt مسدود شوند). - ریدایرکتهای زنجیرهای (3xx): آیا گوگلبات مکرراً URLهای قدیمی را میخزد، فقط برای اینکه به URL جدید ریدایرکت شود؟ این اتلاف محض بودجه است.

- صفحات Non-Canonical: آیا گوگلبات زمان زیادی را صرف خزش صفحاتی میکند که دارای تگ کنونیکال به صفحه دیگری هستند؟

آنالیز لاگ فایل تنها راه قطعی برای درک بهینه سازی بودجه خزش است. شما دقیقاً میبینید که گوگلبات کجا وقت خود را تلف میکند و میتوانید آن مسیرها را مسدود کنید.

۲. پیدا کردن خطاهای خزش (Crawl Errors)

لاگها خطاهایی را نشان میدهند که سرچ کنسول ممکن است هفتهها بعد گزارش دهد (یا اصلاً گزارش ندهد). در آنالیز لاگ فایل، به دنبال این کدهای وضعیت باشید:

- کدهای 4xx (خطاهای کلاینت): اینها اولویت شما هستند. اگر Googlebot مکرراً به صفحات 404 (Not Found) برخورد میکند، بودجه خزش را هدر میدهد و سیگنال کیفیت پایین ارسال میکند. آنالیز لاگ فایل به شما کمک میکند 404های پنهان یا حتی رفع خطای Soft 404 (صفحاتی که کد 200 میدهند اما محتوایی ندارند) را پیدا کنید.

- کدهای 5xx (خطاهای سرور): اینها بحرانی هستند. اگر Googlebot با خطاهای 500 یا 503 مواجه شود، نرخ خزش را به شدت کاهش میدهد (Throttle میکند) یا خزش را به طور کامل متوقف میکند. این نشاندهنده مشکلات جدی در تاثیر هاست و سرور بر سئو است.

۳. تحلیل رفتار گوگل بات (Bot Behavior)

آنالیز لاگ فایل به شما امکان میدهد روانشناسی Googlebot را درک کنید:

- فرکانس خزش (Crawl Frequency): صفحات مهم شما (مانند صفحه اصلی یا مقالات جدید) چقدر سریع پس از انتشار یا بهروزرسانی، خزیده میشوند؟

- خزش موبایل در مقابل دسکتاپ: آیا گوگلبات عمدتاً با User-agent موبایل (Mobile-first indexing) سایت شما را میخزد؟

- خزش منابع (Resource Crawling): آیا Googlebot فایلهای CSS و JS شما را میخزد؟ اگر نه، ممکن است در رندر کردن صفحه شما مشکل داشته باشد.

نتیجهگیری: از دادههای خام به استراتژی فنی برنده

برای «سارا» و هر مدیر فنی، آنالیز لاگ فایل مرز بین سئوی واکنشی (Reactive) و سئوی پیشگیرانه (Proactive) است. سئوکاران عادی منتظر میمانند تا سرچ کنسول به آنها بگوید مشکلی وجود دارد. سئوکاران حرفهای لاگهای خود را تحلیل میکنند تا مشکلات را قبل از اینکه گوگل اصلاً متوجه آنها شود، برطرف کنند.

آنالیز لاگ فایل دیگر یک «تکنیک اختیاری» نیست؛ بلکه بخش اساسی E-E-A-T فنی است. این نشان میدهد که شما نه تنها به آنچه گوگل میگوید گوش میدهید، بلکه فعالانه در حال مشاهده و بهینهسازی نحوه تعامل آن با دارایی دیجیتال خود هستید. این، بالاترین سطح بهینهسازی خزش و ایندکس است.