تست A/B در طراحی: از فرضیه Heatmap تا بهینهسازی نرخ تبدیل (CRO)

برای «سارا»، مدیر بازاریابی فنی، دادهها همهچیز هستند. ابزارهایی مانند گوگل آنالیتیکس به ما میگویند «چه اتفاقی» افتاده است (مثلاً: نرخ تبدیل صفحه فرود ما فقط ۱٪ است). ابزارهایی مانند تحلیل Heatmap به ما میگویند «کجا» مشکل رخ داده است (مثلاً: “هیچکس روی دکمه CTA اصلی کلیک نمیکند”). اما هیچکدام از این ابزارها به طور قطعی به ما نمیگویند که «چگونه» آن را بهینه کنیم. اینجاست که تست A/B در طراحی (A/B Testing) وارد میشود.

آنچه در این مقاله میخوانید

- تست A/B در طراحی: از فرضیه Heatmap تا بهینهسازی نرخ تبدیل (CRO)

- تست A/B چیست؟ (تعریف فنی A/B Testing)

- چرا تست A/B برای CRO و UX حیاتی است؟

- ۱. حذف حدس و گمان و «نظر مدیرعامل» (HiPPO)

- ۲. کاهش ریسک در تغییرات بزرگ

- ۳. بهینهسازی مداوم و تدریجی (Iterative Improvement)

- ۴. درک عمیقتر روانشناسی کاربر

- تفاوت تست A/B و تست Multivariate (A/B vs. MVT)

- ۱. تست A/B (ساده و متمرکز)

- ۲. تست چند متغیره (Multivariate Test – MVT)

- فرآیند گام به گام اجرای تست A/B در طراحی (ورکفلو فنی)

- گام ۱: تحقیق و جمعآوری داده (پیدا کردن «چرا»)

- گام ۲: فرموله کردن فرضیه (Hypothesis)

- گام ۳: طراحی و توسعه متغیر (Control vs. Variation)

- گام ۴: راهاندازی و اجرا (Implementation)

- گام ۵: تحلیل نتایج (و تله اهمیت آماری)

- چه چیزی را در UX تست کنیم؟ (ایدههای تست A/B برای CTA)

- ابزارهای تست A/B (و چالش Core Web Vitals)

- نتیجهگیری: از «فکر میکنم» به «میدانم»

تست A/B چیست؟ این یک آزمایش علمی و کنترلشده است که حدس و گمان را از فرآیند طراحی UI/UX حذف میکند. این فرآیند، ستون فقرات بهینه سازی نرخ تبدیل (CRO) و پلی است که فرضیههای مبتنی بر داده را به نتایج تجاری قابل اندازهگیری تبدیل میکند. این مقاله یک راهنمای فنی عمیق برای «سارا» است تا بیاموزد چگونه تست A/B در UX را به درستی اجرا کند، از تلههای آماری اجتناب نماید و به طور سیستماتیک عناصر UI مانند CTAها را بهینه کند.

تست A/B چیست؟ (تعریف فنی A/B Testing)

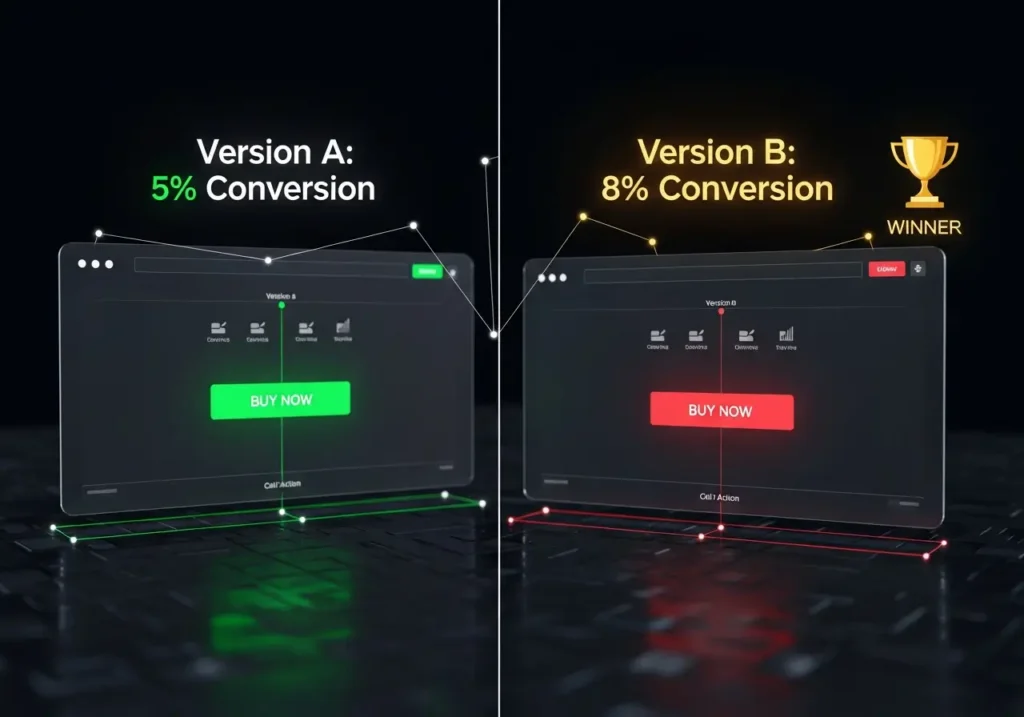

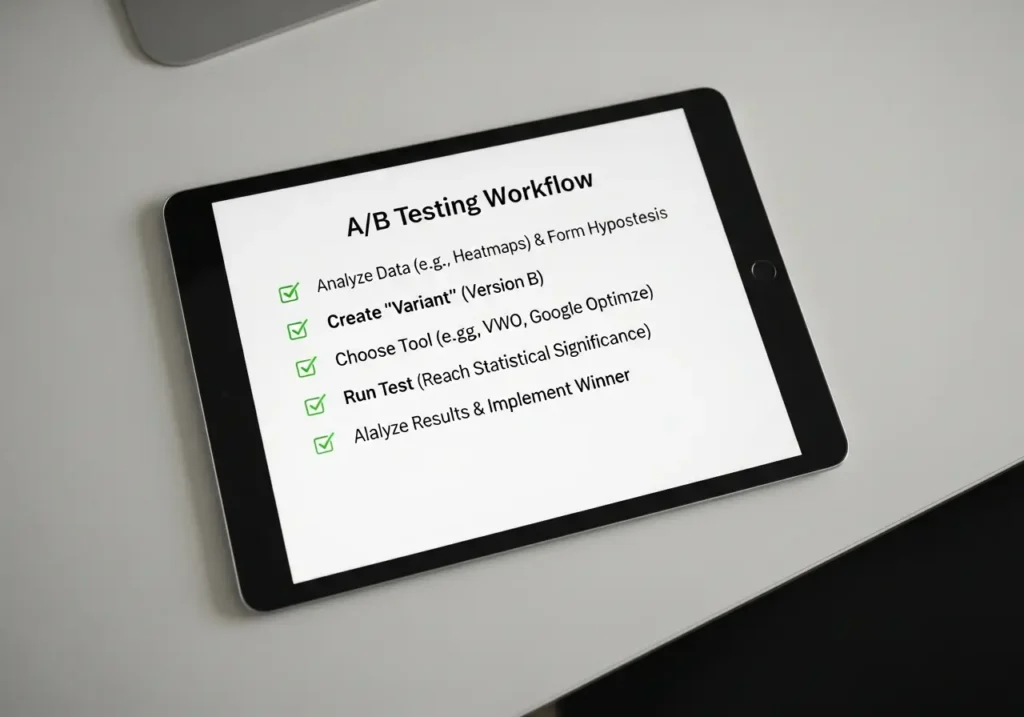

تست A/B، که اغلب به آن «تست تقسیم» (Split Testing) نیز گفته میشود، یک روش تحقیق کمی (Quantitative) در تجربه کاربری است که در آن دو نسخه از یک متغیر (مانند یک صفحه وب، یک دکمه CTA، یا یک تیتر) به صورت همزمان با هم مقایسه میشوند تا مشخص شود کدام نسخه در دستیابی به یک هدف مشخص (Goal) بهتر عمل میکند.

فرآیند A/B Testing به این شکل عمل میکند:

- نسخه A (کنترل): طرح اصلی و فعلی شما (مثلاً دکمه CTA سبز رنگ).

- نسخه B (متغیر): طرح جدیدی که میخواهید آن را تست کنید (مثلاً همان دکمه CTA با رنگ قرمز).

- تقسیم ترافیک: ترافیک ورودی به صفحه به دو گروه مساوی تقسیم میشود. ۵۰٪ نسخه A را میبینند و ۵۰٪ نسخه B را.

- اندازهگیری: شما اندازهگیری میکنید که کدام نسخه، «نرخ تبدیل» (Conversion Rate) بالاتری برای «هدف» (Goal) شما (مثلاً کلیک روی دکمه CTA) داشته است.

نتیجه، یک پاسخ آماری و غیرقابل انکار به این سوال است: “آیا دکمه قرمز بهتر از سبز عمل میکند؟” تست A/B در طراحی، فرآیند تبدیل «من فکر میکنم…» به «من میدانم…» است.

چرا تست A/B برای CRO و UX حیاتی است؟

اجرای تست A/B در UX صرفاً یک تمرین آکادمیک نیست، بلکه یک ضرورت تجاری برای هر سازمانی است که به دنبال رشد مبتنی بر داده است.

۱. حذف حدس و گمان و «نظر مدیرعامل» (HiPPO)

بزرگترین مانع در بهینه سازی نرخ تبدیل (CRO)، پدیدهای به نام “HiPPO” (Highest Paid Person’s Opinion) یا «نظر فردی است که بیشترین حقوق را میگیرد» میباشد. «کیان» (مدیرعامل) ممکن است «احساس» کند که رنگ آبی برای برند بهتر است، اما تست A/B در طراحی به «سارا» اجازه میدهد تا با دادههای واقعی پاسخ دهد. اگر دکمه قرمز ۲۰٪ نرخ کلیک بیشتری نسبت به آبی ایجاد میکند، دادهها برنده بحث خواهند شد. A/B Testing تصمیمگیری را از «مبتنی بر عقیده» به «مبتنی بر رفتار کاربر» تغییر میدهد.

۲. کاهش ریسک در تغییرات بزرگ

بازطراحی کامل صفحه اصلی یک ریسک بزرگ است. اگر طراحی جدید، علیرغم ظاهر زیباتر، نرخ تبدیل را کاهش دهد چه؟ تست A/B در طراحی به شما امکان میدهد این ریسک را مدیریت کنید. به جای جایگزینی ۱۰۰٪ صفحه، شما میتوانید طراحی جدید (B) را در مقابل طراحی قدیمی (A) برای ۱۰٪ یا ۲۰٪ از ترافیک تست کنید. اگر نسخه B برنده شد، شما با اطمینان کامل آن را جایگزین میکنید. اگر شکست خورد، شما از یک فاجعه تجاری جلوگیری کردهاید.

۳. بهینهسازی مداوم و تدریجی (Iterative Improvement)

بهینه سازی نرخ تبدیل (CRO) یک پروژه با نقطه پایان نیست، بلکه یک فرآیند مداوم است. تست A/B در طراحی به شما امکان میدهد تا به طور مداوم فرضیههای جدید را تست کنید.

هفته ۱: تست رنگ CTA (سبز برنده شد).

هفته ۲: تست متن CTA (استفاده از “شروع رایگان” به جای “ثبت نام”).

هفته ۳: تست موقعیت CTA (بالای صفحه بهتر بود).

این بردهای کوچک و تدریجی، در طول یک سال میتوانند تأثیر ترکیبی (Compound Effect) عظیمی بر درآمد داشته باشند.

۴. درک عمیقتر روانشناسی کاربر

تست A/B در UX فقط به دنبال «برد» نیست، بلکه به دنبال «یادگیری» است. اگر تست کنید و ببینید که متن «ضمانت بازگشت وجه ۳۰ روزه» نرخ تبدیل را بیشتر از «تخفیف ۱۰٪» افزایش میدهد، شما یک درس حیاتی در مورد کاربران خود آموختهاید: «آنها بیشتر از تخفیف، به دنبال کاهش ریسک و اعتماد هستند.» این بینش، بسیار ارزشمندتر از خود تست است.

تفاوت تست A/B و تست Multivariate (A/B vs. MVT)

این یک تمایز فنی کلیدی است که «سارا» باید بداند. تست A/B در طراحی اغلب با تست چند متغیره (Multivariate) اشتباه گرفته میشود.

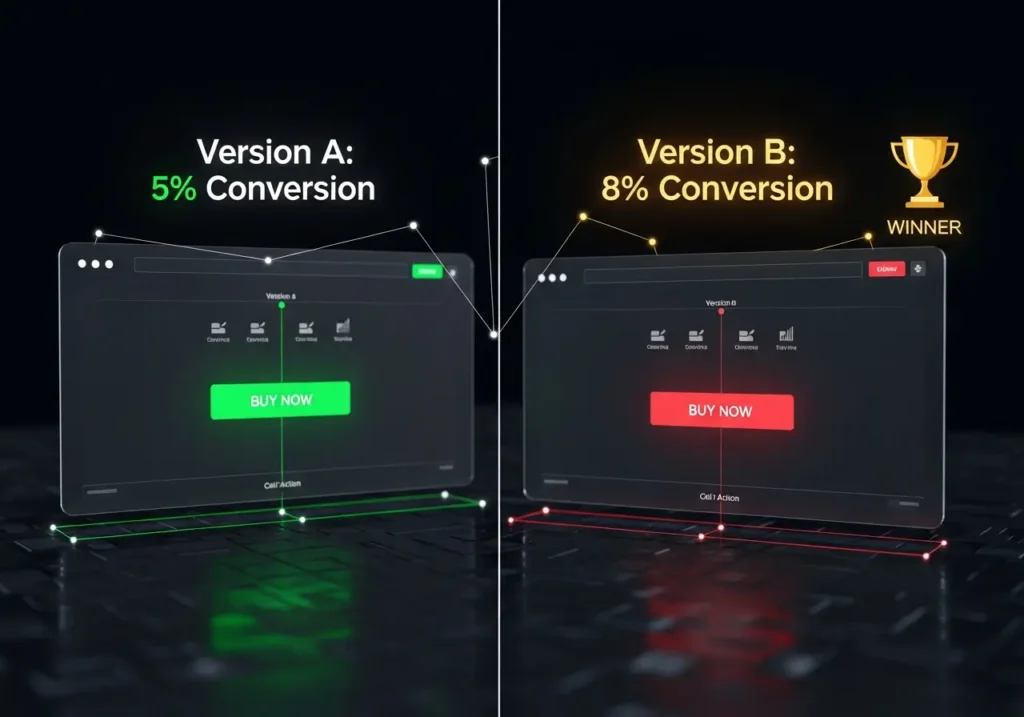

۱. تست A/B (ساده و متمرکز)

- چیست؟ یک متغیر واحد را تست میکند. شما نسخه A (کنترل) را با نسخه B (متغیر) مقایسه میکنید.

- مثال: تیتر اصلی (A) در مقابل تیتر جدید (B).

- هدف: پیدا کردن اینکه کدام «نسخه» (Page Version) بهتر عمل میکند.

- مزایا: پیادهسازی ساده، نتایج سریعتر، نیاز به ترافیک کمتر.

- معایب: اگر چندین تغییر در نسخه B ایجاد کنید (مثلاً هم تیتر و هم رنگ دکمه را عوض کنید)، نمیتوانید بفهمید *کدام* تغییر باعث برد (یا باخت) شده است.

۲. تست چند متغیره (Multivariate Test – MVT)

- چیست؟ چندین متغیر را به طور همزمان تست میکند تا «ترکیب» برنده را پیدا کند.

- مثال: تست ۳ نسخه تیتر (H1, H2, H3) *و* ۲ نسخه تصویر (I1, I2) *و* ۲ نسخه CTA (C1, C2).

- فرآیند: ابزار به طور خودکار تمام ترکیبات ممکن را ایجاد میکند (3x2x2 = 12 ترکیب مختلف) و ترافیک را بین همه آنها تقسیم میکند.

- هدف: پیدا کردن اینکه کدام «ترکیب» (Combination) بهترین عملکرد را دارد (مثلاً H2+I1+C2) و کدام «عنصر» (Element) بیشترین تأثیر را بر تبدیل داشته است.

- مزایا: بینش بسیار عمیقتری در مورد تعامل عناصر با یکدیگر ارائه میدهد.

- معایب: پیادهسازی بسیار پیچیده و به شدت «تشنه ترافیک» (Traffic-Hungry) است. برای به دست آوردن نتایج آماری معتبر، به میلیونها بازدید نیاز دارد.

توصیه فنی برای «سارا»:

برای ۹۹٪ کارهای بهینه سازی نرخ تبدیل (CRO)، از تست A/B در طراحی استفاده کنید. این روش سریع، چابک و برای تست A/B برای CTA یا طراحی فرمهای با نرخ تبدیل بالا عالی است. MVT را فقط برای صفحات با ترافیک بسیار بسیار بالا (مانند صفحه اصلی آمازون) و زمانی که نیاز به درک تعاملات پیچیده عناصر دارید، در نظر بگیرید.

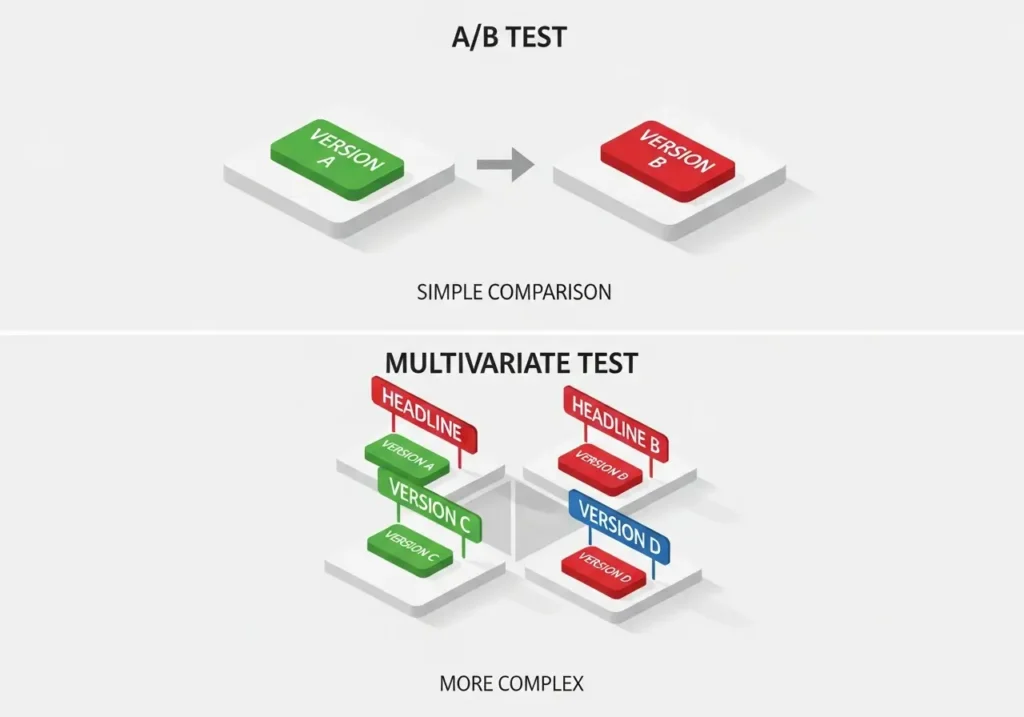

فرآیند گام به گام اجرای تست A/B در طراحی (ورکفلو فنی)

یک تست A/B موفق با یک «ایده» شروع نمیشود؛ با «داده» شروع میشود. این فرآیند علمی، هسته مرکزی بهینه سازی نرخ تبدیل (CRO) است.

گام ۱: تحقیق و جمعآوری داده (پیدا کردن «چرا»)

اولین قدم، پیدا کردن «مشکل» است. شما نباید عناصری را که به خوبی کار میکنند، تست کنید. به دنبال «نشتی» در قیف فروش خود بگردید.

- دادههای کمی (Analytics): گوگل آنالیتیکس را باز کنید. صفحاتی با ترافیک بالا و نرخ خروج (Exit Rate) بالا یا نرخ تبدیل پایین را پیدا کنید. (مثال: صفحه پرداخت ما ۷۰٪ نرخ خروج دارد).

- دادههای کیفی (Heatmaps): این گنجینه شماست. به سراغ تحلیل Heatmap برای آن صفحه خاص بروید.

- Click Map: آیا کاربران روی عناصر غیرقابل کلیک (Rage Clicks) کلیک میکنند؟

- Scroll Map: آیا ۸۰٪ کاربران اصلاً CTA شما را که در پایین صفحه است، میبینند؟

- Session Recordings: چند جلسه ضبط شده را تماشا کنید. ببینید کاربران کجا گیر میکنند، کجا مردد هستند، کجا گیج میشوند.

گام ۲: فرموله کردن فرضیه (Hypothesis)

این، مهمترین گام در کل فرآیند تست A/B چیست. یک تست بدون فرضیه، فقط هدر دادن ترافیک است. فرضیه شما باید مبتنی بر دادههای گام ۱ باشد.

یک فرضیه قوی باید این ساختار را داشته باشد:

“بر اساس [مشاهده/داده]، ما معتقدیم که با [ایجاد این تغییر] برای [این مخاطب]، میتوانیم [این متریک] را بهبود دهیم، زیرا [این دلیل روانشناختی/UX].”

مثال فرضیه (مبتنی بر Heatmap):

مشاهده: “بر اساس تحلیل Heatmap از صفحه لندینگ، ما مشاهده کردیم که 60% کاربران موبایل هرگز به زیر خط تا (Fold) اسکرول نمیکنند، جایی که دکمه CTA اصلی ما قرار دارد.”

فرضیه: “ما معتقدیم که با **انتقال دکمه CTA اصلی به بالای صفحه، دقیقاً زیر تیتر اصلی**، برای **کاربران موبایل**، میتوانیم **نرخ کلیک روی CTA را ۲۰٪ افزایش دهیم**، زیرا **این دکمه اولین عنصری خواهد بود که در Viewport قابل مشاهده است**.”

این فرضیه، خاص، قابل اندازهگیری و قابل تست است.

گام ۳: طراحی و توسعه متغیر (Control vs. Variation)

اکنون نسخه B (Variation یا Challenger) را بر اساس فرضیه خود بسازید.

- نسخه A (Control): صفحه فعلی (CTA در پایین).

- نسخه B (Variation): صفحه جدید (CTA در بالا).

نکته فنی (Isolation): در یک تست A/B خالص، شما باید فقط *یک متغیر* را تغییر دهید. اگر همزمان CTA را به بالا منتقل کنید *و* رنگ آن را تغییر دهید *و* متن آن را عوض کنید، در پایان تست نمیدانید کدام یک از این سه تغییر باعث برد (یا باخت) شده است.

گام ۴: راهاندازی و اجرا (Implementation)

از یکی از ابزارهای تست A/B استفاده کنید (در ادامه بحث میشود). تست خود را پیکربندی کنید:

- تنظیم هدف (Goal): هدف چیست؟ (مثلاً: کلیک روی دکمه CTA با شناسه CSS

#main-cta-button). - تخصیص ترافیک (Traffic Allocation): معمولاً ۵۰٪ به A و ۵۰٪ به B.

- تنظیم مخاطب (Audience): آیا این تست برای همه است یا فقط برای کاربران موبایل؟ (بر اساس فرضیه ما، فقط موبایل).

تست را راهاندازی کنید و *مهمتر از همه، به آن دست نزنید.*

گام ۵: تحلیل نتایج (و تله اهمیت آماری)

اجازه دهید تست تا زمانی که به اندازه نمونه (Sample Size) کافی برسد، اجرا شود. «پیک زدن» (Peeking) روزانه به نتایج، بزرگترین گناه در A/B Testing است.

مفهوم فنی: اهمیت آماری (Statistical Significance)

این مهمترین مفهوم در تست A/B چیست. اهمیت آماری (یا «اطمینان») به شما میگوید که آیا نتیجه تست شما واقعی است یا فقط ناشی از شانس تصادفی بوده است.

- شما به دنبال سطح اطمینان حداقل ۹۵٪ هستید.

- اگر ابزار شما میگوید “نسخه B با اطمینان ۷۰٪ برنده است”، این نتیجه *بیارزش* است. این یعنی ۳۰٪ احتمال دارد که این نتیجه شانسی باشد.

- صبر کنید تا تست به ۹۵٪ برسد. اگر هرگز نرسید، یعنی هیچ برنده واضحی وجود ندارد و تغییر شما تأثیری نداشته است.

منابع معتبری مانند CXL Institute به طور عمیق در این باره صحبت کردهاند.

پس از رسیدن به اهمیت آماری، برنده را اعلام کنید. اگر B برنده شد، آن را برای ۱۰۰٪ ترافیک پیادهسازی کنید. اگر A (کنترل) برنده شد، فرضیه شما اشتباه بود (که این هم یک یادگیری ارزشمند است!). به گام ۱ بازگردید و فرضیه جدیدی بسازید.

چه چیزی را در UX تست کنیم؟ (ایدههای تست A/B برای CTA)

تست A/B برای CTA رایجترین است، اما پتانسیل تست A/B در UX بسیار فراتر است:

- متن CTA: تست تحلیل قصد کاربر. “رایگان شروع کنید” (تمرکز بر هزینه) در مقابل “ثبت نام کنید” (تمرکز بر اقدام) در مقابل “دمو درخواست دهید” (تمرکز بر محصول).

- رنگ و طراحی CTA: قرمز در مقابل سبز، دکمه گوشهگرد در مقابل گوشهتیز، دکمه با سایه در مقابل دکمه تخت.

- بهینهسازی فرم: برای طراحی فرمهای با نرخ تبدیل بالا حیاتی است. آیا حذف فیلد «شماره تلفن» نرخ تکمیل فرم را افزایش میدهد؟

- تیترها و پیشنهادات ارزش (Value Proposition): تست تیتر اصلی صفحه.

- چیدمان (Layout): تست یک ستونه در مقابل دو ستونه.

- رسانه (Media): تصویر محصول در مقابل ویدئوی محصول.

- اثبات اجتماعی (Social Proof): نمایش نظرات مشتریان در بالای صفحه در مقابل پایین صفحه.

ابزارهای تست A/B (و چالش Core Web Vitals)

انتخاب ابزارهای تست A/B بر نحوه اجرای تست تأثیر میگذارد.

- ابزارهای Client-Side (سمت کلاینت):

- مثالها: VWO, Optimizely, Convert.com, (و Google Optimize که منسوخ شد).

- چگونه کار میکنند: یک اسکریپت جاوا اسکریپت واحد در سایت شما بارگذاری میشود. این اسکریپت پس از بارگذاری صفحه، DOM را دستکاری میکند تا نسخه B را به کاربر نشان دهد (مثلاً رنگ دکمه را در مرورگر تغییر میدهد).

- مزایا: استفاده آسان برای «سارا» (بازاریابان) بدون نیاز به توسعهدهنده.

- معایب (بسیار مهم): میتوانند فاجعهبار باشند. این فرآیند باعث «چشمک زدن» (Flickering) میشود (کاربر برای لحظهای نسخه A را میبیند و سپس به B تغییر میکند). این یک تجربه کاربری بد است و میتواند به شدت بر بهینهسازی Core Web Vitals، به خصوص CLS و LCP، تأثیر منفی بگذارد.

- ابزارهای Server-Side (سمت سرور):

- چگونه کار میکنند: قبل از اینکه صفحه به مرورگر کاربر ارسال شود، سرور تصمیم میگیرد که نسخه A یا B را ارسال کند. کاربر مستقیماً نسخه صحیح را دریافت میکند.

- مزایا: بدون چشمک زدن. صفر درصد تأثیر منفی بر CWV. بسیار قدرتمند.

- معایب: پیادهسازی بسیار فنی است و نیازمند دخالت کامل تیم توسعه (Back-end) است.

توصیه برای «سارا»: برای تستهای ساده CTA، ابزارهای Client-Side (مانند VWO) قابل قبول هستند، *به شرطی که* اسکریپت آنها به صورت Asynchronous و بهینه بارگذاری شود. برای تستهای پیچیده چیدمان، تست Server-Side همیشه برنده است.

نتیجهگیری: از «فکر میکنم» به «میدانم»

تست A/B در طراحی فرآیند تبدیل شهود به واقعیت و هنر به علم است. این موتور محرک بهینه سازی نرخ تبدیل (CRO) و تنها راه واقعی برای اثبات این است که یک تغییر در طراحی UI/UX منجر به رشد واقعی کسبوکار میشود.

برای «سارا» و «کیان»، پذیرش فرهنگ A/B Testing به معنای پایان دادن به بحثهای سلیقهای و شروع یک گفتگوی مبتنی بر داده است. هر تستی، چه برنده شود و چه شکست بخورد، یک «یادگیری» ارزشمند در مورد کاربران شماست و هر یادگیری، شما را یک قدم به تجربه کاربری بینقص نزدیکتر میکند.