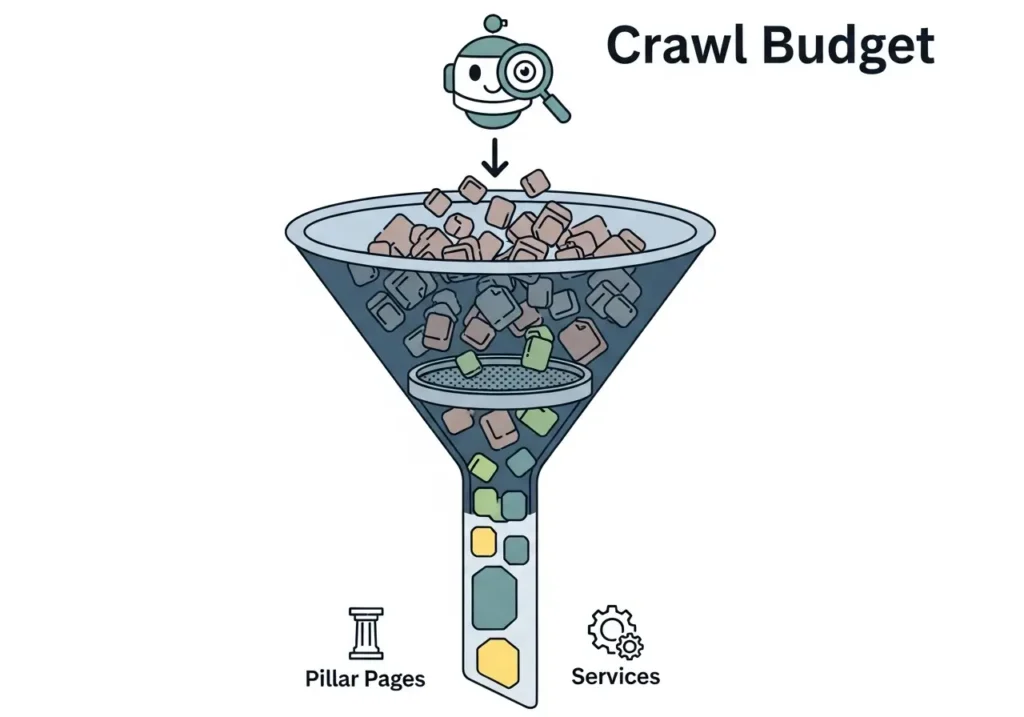

در وبسایتهای بزرگ و Enterprise، تمام صفحات شما ارزشمند نیستند، اما منابع گوگل برای خزش (Crawl) محدود است. اگر گوگل زمان خود را صرف خزش صفحات بیاهمیت، تکراری یا فیلترهای جستجو کند، صفحات کلیدی و پولساز شما از ایندکس باز میمانند. «بهینهسازی بودجه خزش» تضمین میکند که منابع گوگل دقیقاً صرف صفحاتی میشود که برای کسبوکار شما اهمیت دارند.

خدمات بهینهسازی بودجه خزش | رفع مشکلات Crawl و Indexing در گوگل

چرا «بهینهسازی بودجه خزش» حیاتیترین بخش سئو فنی است؟

در آژانس آدرینالیز، ما معتقدیم که ایندکس شدن (Indexing) یک امتیاز است، نه یک حق. قبل از اینکه بتوانید رتبه بگیرید، باید ایندکس شوید؛ و قبل از اینکه ایندکس شوید، باید به درستی خزش (Crawl) شوید. برای وبسایتهای گسترده، مدیریت این فرآیند، یعنی بهینه سازی بودجه خزش (Crawl Budget)، تفاوت میان موفقیت و شکست کمپینهای سئو را رقم میزند.

هدر دادن بودجه خزش به معنای نادیده گرفته شدن صفحات فرود جدید، مقالات مهم وبلاگ و محصولات کلیدی شما توسط گوگل است. این مشکل مستقیماً به کاهش ترافیک ارگانیک و از دست رفتن درآمد منجر میشود. خدمات ما بر این تمرکز دارد که اطمینان حاصل شود تک تک درخواستهای خزش (Crawl Request) گوگل، صرف صفحات ارزشمند شما میشود.

تعریف فنی Crawl Budget (بودجه خزش)

بودجه خزش، مفهومی است که توسط گوگل برای توصیف تعداد صفحاتی که رباتهای گوگل (Googlebot) میتوانند و میخواهند در یک بازه زمانی مشخص در وبسایت شما بخزند، استفاده میشود. این یک معیار مطلق نیست، بلکه ترکیبی از دو فاکتور اصلی است که درک آنها برای بودجه خزش چیست؟ و بهینهسازی آن ضروری است.

دو عامل کلیدی تعیینکننده بودجه خزش

فرآیند بهینه سازی بودجه خزش (Crawl Budget) مستلزم مدیریت همزمان این دو فاکتور است:

- محدودیت نرخ خزش (Crawl Rate Limit): این بخش مربوط به سلامت سرور (Crawl Health) شماست. گوگلبات به صورت هوشمند، سرور شما را مانیتور میکند. اگر سرور شما کند باشد یا با خطاهای سری 5xx (Server Errors) پاسخ دهد، گوگل به طور خودکار نرخ خزش را کاهش میدهد تا به وبسایت شما آسیب نرساند. کاهش سرعت سایت و تاثیر آن بر بودجه خزش یک ارتباط مستقیم و حیاتی است.

- تقاضای خزش (Crawl Demand): این بخش مربوط به اهمیت و محبوبیت (Popularity) و تازگی (Freshness) محتوای شماست. اگر صفحات شما محبوب باشند (بکلینکهای باکیفیت داشته باشند) یا به طور مرتب بهروزرسانی شوند، گوگل تمایل بیشتری برای خزش مکرر آنها خواهد داشت. وبسایتهای اسپم یا کمارزش، تقاضای خزش پایینی دارند.

نشانههای هدررفت بودجه خزش (Crawl Budget Waste)

چگونه متوجه شویم که نیازمند خدمات بهینه سازی بودجه خزش (Crawl Budget) هستیم؟ اگر مدیر بازاریابی فنی یا متخصص سئو هستید، این نشانهها باید برای شما زنگ خطر باشند:

- ایندکس شدن صفحات جدید (مانند مقالات وبلاگ یا محصولات) هفتهها طول میکشد.

- صفحات فیلتر (Faceted Navigation)، پارامترهای URL (مانند ?source=) یا صفحات جستجوی داخلی سایت در نتایج گوگل ایندکس شدهاند.

- گزارش Coverage در سرچ کنسول، تعداد بسیار بالایی از صفحات “Excluded” را نشان میدهد.

- تغییرات اعمال شده در محتوای صفحات مهم، به کندی در نتایج گوگل منعکس میشوند.

- در آنالیز لاگ فایل، گوگلبات زمان زیادی را صرف خزش صفحات ریدایرکت شده، خطاهای 404 یا صفحات بیاهمیت میکند.

نکته کلیدی: هدررفت بودجه خزش یک مشکل نامرئی است که به طور مستقیم بر درآمدزایی (ROI) سئو تاثیر میگذارد. فرآیند بهینه سازی بودجه خزش (Crawl Budget) اطمینان میدهد که منابع گوگل صرف کشف و ایندکس محتوایی میشود که مستقیماً به اهداف تجاری (KPIs) شما مرتبط است.

آنالیز لاگ فایل: ردیابی دقیق رفتار گوگلبات

تنها راه برای درک قطعی اینکه بودجه خزش شما چگونه مصرف میشود، آنالیز لاگ فایل سرور است. گزارشهای سرچ کنسول تنها یک نمای کلی (Sampled Data) ارائه میدهند، اما لاگ فایلها هر بازدید (Hit) گوگلبات به سرور شما را ثبت میکنند. تیم فنی آدرینالیز با تحلیل لاگ فایلها مشخص میکند که گوگلبات دقیقاً کدام صفحات را میخزد، چند بار میخزد و چه مقدار از بودجه خزش صرف صفحات زائد میشود. این دادهها، سنگ بنای استراتژی بهینه سازی بودجه خزش ما هستند.

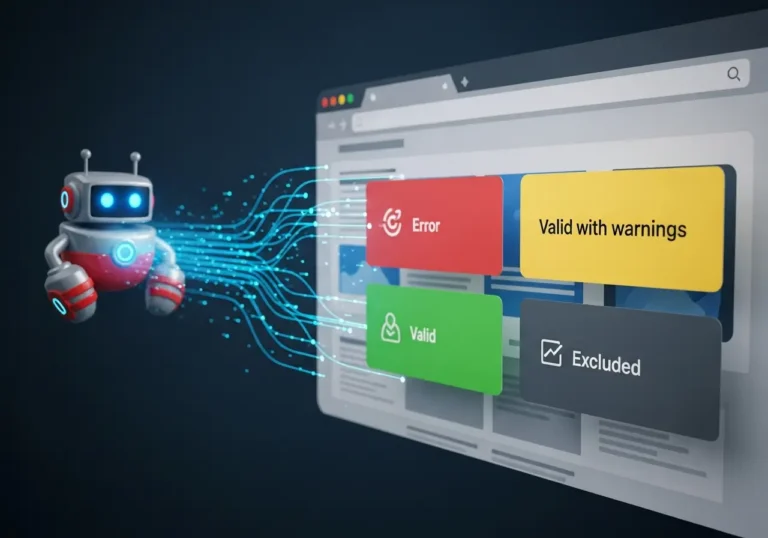

رفع خطاهای حیاتی Coverage: پاکسازی مسیر خزش

اولین قدم در هر پروژه بهینه سازی بودجه خزش (Crawl Budget)، بررسی دقیق گزارش Coverage در گوگل سرچ کنسول است. این گزارش به ما میگوید که گوگل هنگام تلاش برای ایندکس کردن سایت شما با چه موانعی روبرو شده است. نادیده گرفتن این خطاها به معنای پذیرش هدررفت منابع خزش است.

ما در آدرینالیز، به طور سیستماتیک تمام خطاهای Coverage سرچ کنسول را بررسی و رفع میکنیم تا مسیر خزش برای گوگلبات هموار شود.

خطای Discovered – currently not indexed

این یکی از رایجترین و گیجکنندهترین خطاهاست. این وضعیت به این معناست که گوگل صفحه شما را پیدا کرده، اما تصمیم گرفته آن را نخزد. چرا؟ معمولاً به دلیل کمبود بودجه خزش. گوگل تشخیص داده که خزش این صفحه در حال حاضر اولویت ندارد، زیرا ممکن است سرور شما کند باشد یا سایت شما آنقدر صفحات کماهمیت داشته باشد که گوگل ترجیح داده خزش را به تعویق بیندازد. رفع خطای Discovered – currently not indexed مستقیماً به بهینه سازی بودجه خزش (Crawl Budget) وابسته است.

خطای Crawled – currently not indexed

این خطا یک پله بدتر است. گوگل بودجه خزش را صرف کرده و صفحه را بررسی کرده، اما تصمیم گرفته آن را ایندکس نکند. این معمولاً نشاندهنده مشکلات کیفیت محتوا (Thin Content) یا محتوای تکراری است. اگرچه این یک مشکل کیفی است، اما هدررفت بودجه خزش را نیز نشان میدهد؛ گوگل منبعی را صرف کرده که نتیجهای در پی نداشته است.

خطای Soft 404

این خطا زمانی رخ میدهد که یک صفحه “Not Found” (که باید کد 404 برگرداند)، به اشتباه کد 200 (OK) برمیگرداند. گوگل این صفحات را میخزد، آنها را خالی یا کمارزش مییابد و آنها را به عنوان Soft 404 علامتگذاری میکند. این صفحات به شدت بودجه خزش را هدر میدهند. رفع خطای Soft 404 و اطمینان از ارسال کدهای وضعیت (Status Code) صحیح، بخش مهمی از بهینهسازی خزش است.

خطاهای ریدایرکت (Redirect Errors & Chains)

زنجیرههای ریدایرکت (Redirect Chains)، مانند A > B > C > D، قاتل بودجه خزش هستند. گوگلبات ممکن است پس از دنبال کردن دو یا سه ریدایرکت، فرآیند خزش را متوقف کند. هر ریدایرکت یک درخواست جداگانه به سرور است که بودجه خزش مصرف میکند. اهمیت Redirect 301 و Redirect Chain در این است که با رفع آنها و تبدیل ریدایرکتهای زنجیرهای به ریدایرکتهای 301 مستقیم (A > D)، فرآیند بهینه سازی بودجه خزش به شکل موثری انجام میشود.

مدیریت استراتژیک ایندکس و جلوگیری از محتوای تکراری

پس از پاکسازی خطاهای Coverage، گام بعدی مدیریت فعال صفحاتی است که گوگل باید (و نباید) ایندکس کند. هدف اصلی در این مرحله، تجمیع سیگنالهای رتبهبندی و جلوگیری از تقسیم شدن اعتبار (Link Equity) میان صفحات تکراری است. این کار به طور غیرمستقیم به بهینه سازی بودجه خزش (Crawl Budget) کمک میکند، زیرا گوگل یاد میگیرد که کدام نسخه از صفحه، نسخه اصلی است.

پیادهسازی تگ کنونیکال (Canonical Tag): تجمیع اعتبار

تگ کنونیکال (rel="canonical") مهمترین ابزار شما برای مقابله با محتوای تکراری (Duplicate Content) است. این تگ به گوگل میگوید که کدام URL نسخه “ترجیحی” یا “اصلی” یک صفحه است، به خصوص زمانی که محتوای یکسان یا بسیار مشابه از طریق URLهای مختلف (مانند پارامترهای UTM، نسخههای چاپی، یا فیلترهای مرتبسازی) در دسترس است.

یک پیادهسازی تگ کنونیکال بینقص، سیگنالهای متناقض را حذف میکند. این کار به گوگل کمک میکند تا اعتبار همه نسخههای تکراری را در یک URL واحد تجمیع کند و بودجه خزش خود را بر روی آن نسخه اصلی متمرکز سازد، به جای اینکه آن را میان چندین URL تکراری تقسیم کند. این فرآیند بخشی حیاتی از بهینه سازی بودجه خزش (Crawl Budget) است.

مدیریت مستقیم خزش: بهینهسازی فایل Robots.txt

در حالی که تگ کنونیکال و Noindex برای مدیریت “ایندکس” هستند، فایل robots.txt ابزار اصلی شما برای مدیریت “خزش” است. این فایل اولین جایی است که گوگلبات قبل از خزش هر صفحهای در سایت شما به آن مراجعه میکند. استفاده نادرست از آن میتواند فاجعهبار باشد، اما استفاده استراتژیک از آن، قدرتمندترین روش برای بهینه سازی بودجه خزش (Crawl Budget) است.

راهنمای فنی بهینهسازی فایل Robots.txt

هدف از بهینهسازی فایل robots.txt این نیست که گوگل را از صفحات مهم دور نگه داریم، بلکه این است که به طور فعال، گوگل را از خزش بخشهای بیارزش و تکراری وبسایت منع کنیم. این کار باعث میشود بودجه خزش آزاد شده، صرف صفحات مهمتر شود.

بخشهایی که معمولاً باید از طریق Disallow مسدود شوند عبارتند از:

- URLهای دارای پارامترهای فیلتر (Faceted Navigation) که هزاران ترکیب URL تکراری ایجاد میکنند.

- نتایج جستجوی داخلی سایت (

/search?q=). - صفحات مربوط به حساب کاربری، سبد خرید و فرآیندهای پرداخت.

- صفحات ورود و ثبت نام (Login/Register).

- نسخههای چاپی (Print-friendly) صفحات.

مهم است که هرگز فایلهای CSS، JavaScript یا فایلهای تصویری حیاتی را Disallow نکنید، زیرا گوگل برای رندر صحیح صفحه (Rendering) و درک محتوا به آنها نیاز دارد. مسدود کردن این منابع میتواند منجر به تشخیص نادرست محتوا و مشکلات ایندکس شود.

هشدار فنی حیاتی: تفاوت

Disallowدر Robots.txt و تگnoindexرا درک کنید.

- Disallow: به گوگل میگوید “این صفحه را نخز”. اگر صفحهای قبلاً ایندکس شده باشد، Disallow کردن آن باعث حذفش از ایندکس نمیشود. آن صفحه در نتایج باقی میماند (اغلب با عنوان “No information is available for this page”). این دستور مستقیماً برای بهینه سازی بودجه خزش (Crawl Budget) به کار میرود.

- Noindex: به گوگل میگوید “این صفحه را خزش کن، اما آن را در نتایج جستجو نشان نده”. این دستور بودجه خزش را مصرف میکند اما صفحه را از ایندکس حذف میکند.

هرگز صفحهای را که میخواهید

noindexشود،Disallowنکنید، زیرا گوگلبات باید بتواند صفحه را بخزد تا تگnoindexرا ببیند.

استراتژی ایندکسینگ: اطمینان از دیده شدن صفحات مهم

پس از اینکه با استفاده از robots.txt جلوی خزش صفحات بیارزش را گرفتیم، اکنون باید به گوگل بگوییم با صفحاتی که میخزد، چگونه رفتار کند. اینجاست که تفاوت میان مدیریت “خزش” و مدیریت “ایندکس” مشخص میشود. هدف ما در این مرحله، هدایت گوگل به سمت ایندکس کردن صفحات ارزشمند و حذف صفحات کمارزش از نتایج جستجو است.

استفاده استراتژیک از تگ Noindex

تگ متا noindex دستوری است که به گوگل اجازه میدهد صفحه را بخزد (و بودجه خزش مصرف کند)، اما به آن میگوید که صفحه را در نتایج جستجو نمایش ندهد. این ابزار برای صفحاتی مفید است که باید به دلایلی (مانند دسترسی کاربران) وجود داشته باشند، اما هیچ ارزش سئویی ندارند.

چگونگی استفاده استراتژیک از تگ noindex بخش مهمی از پاکسازی ایندکس گوگل است. صفحاتی مانند نتایج جستجوی داخلی (که نباید در robots.txt مسدود شوند تا گوگل بتواند noindex را ببیند)، صفحات آرشیو ضعیف (مانند آرشیوهای زمانی) یا صفحات تشکر از خرید، کاندیداهای خوبی برای noindex هستند. حذف این صفحات کمکیفیت از ایندکس گوگل، به طور غیرمستقیم به بهینه سازی بودجه خزش (Crawl Budget) کمک میکند، زیرا گوگل اعتبار کلی دامنه شما را بالاتر ارزیابی کرده و منابع بیشتری را به صفحات باکیفیت شما اختصاص میدهد.

بهینهسازی نقشه سایت (Sitemap.xml)

نقشه سایت (Sitemap) یک “اعلامیه” به گوگل است که میگوید: “اینها مهمترین صفحات من هستند”. اگرچه ارائه نقشه سایت تضمینی برای خزش یا ایندکس نیست، اما یک نقشه سایت تمیز و بهینه، فرآیند کشف (Discovery) صفحات جدید را تسریع میبخشد.

یک اشتباه رایج که منجر به هدررفت بودجه خزش میشود، داشتن نقشه سایت “کثیف” است. نقشه سایت شما باید **فقط** شامل URLهای زیر باشد:

- صفحاتی که کد وضعیت 200 (OK) برمیگردانند.

- صفحات کنونیکال (یعنی URLهایی که به خودشان کنونیکال شدهاند، نه صفحاتی که به URL دیگری کنونیکال دارند).

- صفحاتی که

noindex**نیستند**. - صفحاتی که در

robots.txtمسدود (Disallowed) **نشدهاند**.

ارسال نقشه سایتی که پر از ریدایرکتها، خطاهای 404 یا صفحات noindex باشد، سیگنالهای متناقضی به گوگل ارسال کرده و فرآیند بهینه سازی بودجه خزش (Crawl Budget) شما را تضعیف میکند.

تکنیکهای پیشرفته برای ایندکس سریع صفحات (Fast Indexing)

برای مدیران بازاریابی فنی، به خصوص در وبسایتهای خبری، فروشگاهی (برای کمپینهای فصلی) یا سایتهای آگهی، سرعت ایندکس شدن اهمیت حیاتی دارد. صرفاً بهینه سازی بودجه خزش (Crawl Budget) کافی نیست؛ ما باید گوگل را متقاعد کنیم که صفحات جدید ما را در اولویت خزش قرار دهد.

استفاده از Indexing API گوگل

Indexing API گوگل ابزاری قدرتمند برای درخواست خزش فوری صفحات است. اگرچه گوگل رسماً اعلام کرده که این API عمدتاً برای صفحات شغلی (JobPosting) و پخش زنده (BroadcastEvent) است، اما تجربه فنی نشان داده که برای انواع دیگر صفحات نیز به طور موثری عمل میکند. ما در آدرینالیز از این API به صورت استراتژیک برای اطلاعرسانی به گوگل در مورد صفحات بسیار مهم و زمانبندیشده (Time-Sensitive) استفاده میکنیم. این یکی از موثرترین روشهای ایندکس سریع صفحات است که مستقیماً صف خزش عادی را دور میزند.

تقویت لینکسازی داخلی (Internal Linking)

یکی از قویترین سیگنالها برای تعیین تقاضای خزش (Crawl Demand)، ساختار لینکسازی داخلی شماست. صفحاتی که در عمق زیاد معماری سایت (Deep Architecture) قرار دارند یا به اصطلاح “یتیم” (Orphaned) هستند (هیچ لینک داخلی دریافت نمیکنند)، به ندرت توسط گوگل خزیده میشوند.

بخشی از خدمات بهینه سازی بودجه خزش (Crawl Budget) ما شامل ممیزی و اصلاح ساختار لینکسازی داخلی است. با اطمینان از اینکه صفحات جدید و مهم شما از صفحات با اعتبار بالا (مانند صفحه اصلی یا مقالات پربازدید) لینک دریافت میکنند، ما به گوگل سیگنال میدهیم که این صفحات اهمیت بالایی دارند و باید به سرعت خزیده و ایندکس شوند.

ممیزی سلامت خزش (Crawl Health Audit): فراتر از سرچ کنسول

دادههای سرچ کنسول عالی هستند، اما کامل نیستند. برای یک بهینه سازی بودجه خزش (Crawl Budget) در سطح Enterprise، ما به دادههای خام نیاز داریم. تحلیل لاگ فایلها (Log File Analysis) به ما نشان میدهد که گوگلبات دقیقاً چه میکند، نه آنچه گوگل تصمیم میگیرد در گزارشهای خود به ما نشان دهد.

بهینهسازی پارامترهای URL و Faceted Navigation

در وبسایتهای فروشگاهی، بزرگترین عامل هدررفت بودجه خزش، نویگیشن چندوجهی (Faceted Navigation) یا همان فیلترها (مانند رنگ، سایز، قیمت) است. این فیلترها میتوانند میلیونها ترکیب URL منحصربهفرد اما با محتوای تکراری ایجاد کنند (مانند /shirts?color=blue&size=M و /shirts?size=M&color=blue).

گوگلبات در این “تله خزش” (Crawl Trap) گرفتار شده و تمام بودجه خزش خود را صرف این صفحات بیارزش میکند. استراتژی ما برای مدیریت این فاجعه چندلایه است:

- Robots.txt: مسدود کردن پارامترهایی که هیچ ارزشی ندارند (مانند

sort=price-desc). - Canonical Tag: استفاده از تگ کنونیکال برای اشاره به صفحه دستهبندی اصلی (

/shirts) از تمام ترکیبات فیلتر. - Google Search Console: استفاده از ابزار URL Parameter Handling (اگرچه قدیمیتر است) برای راهنمایی گوگل در مورد نحوه برخورد با پارامترهای خاص.

مدیریت صحیح پارامترها، قلب تپنده بهینه سازی بودجه خزش (Crawl Budget) در سایتهای بزرگ است.

مدیریت کدهای وضعیت (Status Codes)

سلامت سرور (Crawl Health) مستقیماً بر محدودیت نرخ خزش (Crawl Rate Limit) تاثیر میگذارد. هر درخواستی که با خطای سرور (5xx) پاسخ داده شود، به گوگل سیگنال میدهد که سرور شما ناپایدار است و باید سرعت خزش را کاهش دهد.

نکته فنی پیشرفته: تفاوت 301 و 302 در بودجه خزش.

استفاده مداوم از ریدایرکتهای 302 (موقت) به جای 301 (دائم) یک اشتباه رایج در بهینه سازی بودجه خزش است. وقتی گوگل یک 302 را میبیند، URL اصلی را در ایندکس نگه میدارد و مجبور است به طور مکرر بازگردد تا بررسی کند آیا ریدایرکت هنوز پابرجاست یا خیر. این کار بودجه خزش را هدر میدهد. در مقابل، 301 سیگنال میدهد که URL برای همیشه منتقل شده، اعتبار منتقل میشود و گوگل نیازی به خزش مجدد URL قدیمی ندارد.

چرا آژانس آدرینالیز را برای بهینهسازی Crawl Budget انتخاب کنید؟

بهینه سازی بودجه خزش (Crawl Budget) یک اقدام یکباره نیست؛ این یک فرآیند مستمر فنی، دقیق و مبتنی بر داده است. بسیاری از آژانسها صرفاً خطاهای Coverage سرچ کنسول را رفع میکنند، اما ما در آدرینالیز عمیقتر میشویم.

تیم ما متشکل از متخصصان سئو فنی است که رفتار گوگلبات را از طریق آنالیز لاگ فایل درک میکنند. ما استراتژیهایی را پیادهسازی میکنیم که تضمین میکند منابع محدود گوگل نه تنها هدر نمیرود، بلکه به صورت استراتژیک بر روی صفحاتی متمرکز میشود که مستقیماً به اهداف تجاری (KPIs) شما کمک میکنند.

ما اطمینان میدهیم که محتوای ارزشمند شما کشف، خزیده و به سرعت ایندکس میشود. اگر با مشکلات ایندکس دستوپنجه نرم میکنید یا احساس میکنید صفحات مهم شما در میان انبوه URLهای سایتتان گم شدهاند، خدمات سئو فنی حرفهای ما راهحل قطعی برای بهینه سازی بودجه خزش (Crawl Budget) شماست.