راهنمای جامع بهینه سازی robots.txt: دروازهبان استراتژیک Crawl Budget

در دنیای سئو فنی، فایل robots.txt به مثابه اولین نقطه تماس، یا «دروازهبان» وبسایت شما برای رباتهای موتور جستجو (مانند Googlebot) است. برای «سارا»، مدیر بازاریابی فنی، درک این فایل متنی ساده اما قدرتمند، فقط یک چکلیست فنی نیست؛ بلکه سنگ بنای مدیریت بودجه خزش با robots.txt و بخش جداییناپذیری از استراتژی کلان بهینهسازی خزش و ایندکس است.

آنچه در این مقاله میخوانید

- راهنمای جامع بهینه سازی robots.txt: دروازهبان استراتژیک Crawl Budget

- robots.txt چیست؟ (تعریف فنی)

- چرا بهینه سازی robots.txt برای بودجه خزش حیاتی است؟

- آناتومی و سینتکس فایل robots.txt: آموزش کامل دستورات

- ۱. دستور User-agent: هدفگیری رباتها

- ۲. دستور Disallow در robots.txt: فرمان مسدودسازی

- ۳. دستور Allow: ایجاد استثنا (مخصوص گوگل)

- ۴. استفاده از Wildcards (* و $)

- تفاوت حیاتی Disallow و Noindex: خزش در برابر ایندکس

- ۱. دستور Disallow در robots.txt (جلوگیری از خزش)

- ۲. استراتژی تگ noindex (جلوگیری از ایندکس)

- اشتباهات رایج و مرگبار در بهینه سازی robots.txt

- ۱. فاجعه: بلاک کردن کل سایت (Disallow: /)

- ۲. بلاک کردن فایلهای CSS و JavaScript (مشکل رندرینگ)

- ۳. استفاده از دستورات منسوخ شده (Noindex و Crawl-delay)

- ۴. اشتباه در بزرگی و کوچکی حروف (Case-Sensitivity)

- نمونه فایل robots.txt برای وردپرس (یک الگوی بهینه)

- تست فایل robots.txt قبل از انتشار

- نتیجهگیری: robots.txt، دروازهبان استراتژیک Crawl Budget

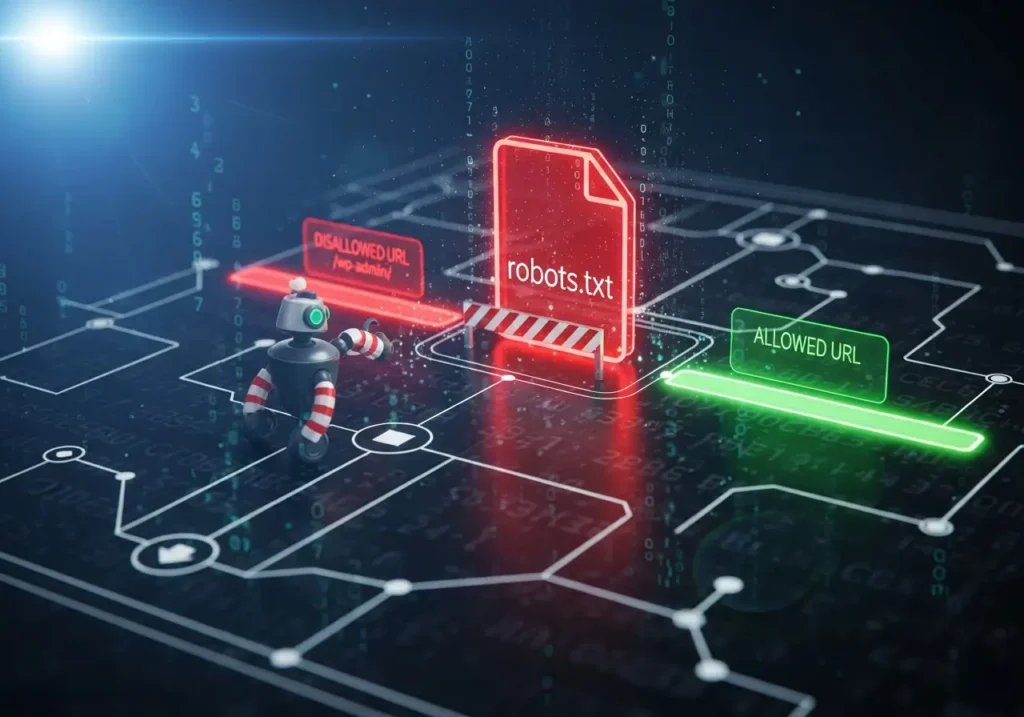

بسیاری به اشتباه فکر میکنند robots.txt ابزاری برای «جلوگیری از ایندکس» است، در حالی که مأموریت اصلی آن «جلوگیری از خزش» و هدایت منابع ارزشمند گوگل به سمت محتوای مهم شماست. تسلط بر بهینه سازی robots.txt به معنای در دست گرفتن کنترل نحوه تعامل گوگل با سایت شما و حفاظت از بودجه خزش (Crawl Budget) است.

robots.txt چیست؟ (تعریف فنی)

فایل robots.txt یک فایل متنی ساده (Plain Text) است که در دایرکتوری ریشه (Root Directory) وبسایت شما قرار میگیرد (مثلاً: https://example.com/robots.txt). این فایل از «پروتکل محرومسازی رباتها» (Robots Exclusion Protocol – REP) پیروی میکند تا به رباتهای موتور جستجو بگوید که کدام بخشها یا فایلهای وبسایت شما را *نباید* بخزند (Crawl نکنند).

نکته فنی بسیار مهم: robots.txt یک «دستورالعمل» (Guideline) است، نه یک «قانون» اجباری. رباتهای معتبر (مانند Googlebot، Bingbot) به این دستورالعملها احترام میگذارند، اما رباتهای مخرب (Scrapers, Spambots) آن را کاملاً نادیده میگیرند. بنابراین، robots.txt هرگز نباید برای مقاصد امنیتی یا مخفی کردن اطلاعات حساس استفاده شود.

چرا بهینه سازی robots.txt برای بودجه خزش حیاتی است؟

اینجاست که اهمیت موضوع برای «سارا» به اوج میرسد. گوگل برای خزش هر وبسایت، منابع محدودی را تخصیص میدهد که به آن «بودجه خزش» یا Crawl Budget گفته میشود. درک عمیق این مفهوم، کلید بهینه سازی بودجه خزش است.

هر وبسایت مدرن، به خصوص سایتهای وردپرسی یا فروشگاههای اینترنتی، هزاران URL بیارزش یا تکراری تولید میکند: صفحات مدیریت (/wp-admin/)، نتایج جستجوی داخلی (/?s=)، URLهای پارامتری (فیلترها، سورتینگ) و فایلهای لاگ. اینها بخشهایی از یک معماری اطلاعات سایت هستند که نباید در دسترس رباتها باشند.

اگر Googlebot بودجه ارزشمند خود را صرف خزش این صفحات بیاهمیت کند، منابع (و زمان) کافی برای یافتن و خزش مقالات جدید، صفحات محصول مهم یا محتوای اصلی شما نخواهد داشت. بهینه سازی robots.txt به معنای استفاده استراتژیک از دستور Disallow در robots.txt برای جلوگیری از خزش گوگل در این بخشها است. این کار، بودجه خزش را حفظ کرده و آن را به سمت صفحاتی که واقعاً اهمیت دارند، هدایت میکند.

آناتومی و سینتکس فایل robots.txt: آموزش کامل دستورات

فایل robots.txt از یک سینتکس بسیار ساده مبتنی بر خطوط مجزا پیروی میکند که شامل «دستور» (Directive) و «مقدار» (Value) است. درک این سینتکس، پایه و اساس بهینه سازی robots.txt است.

۱. دستور User-agent: هدفگیری رباتها

هر مجموعه از قوانین در robots.txt با دستور User-agent آغاز میشود. این دستور مشخص میکند که قوانین بعدی برای کدام ربات (عامل کاربر) اعمال میشوند.

User-agent: *(ستاره): این یک Wildcard است و به معنای «همه رباتها» میباشد. این رایجترین دستور مورد استفاده است.User-agent: Googlebot: قوانین فقط برای ربات اصلی گوگل اعمال میشود.User-agent: Bingbot: قوانین فقط برای ربات بینگ اعمال میشود.

شما میتوانید چندین بلاک User-agent برای رباتهای مختلف داشته باشید.

۲. دستور Disallow در robots.txt: فرمان مسدودسازی

این قلب تپنده بهینه سازی robots.txt و ابزار اصلی شما برای مدیریت بودجه خزش با robots.txt است. Disallow به User-agent مشخص شده میگوید که کدام مسیر (Path) را *نباید* بخزد.

# بلاک کردن یک دایرکتوری خاص User-agent: * Disallow: /wp-admin/ # بلاک کردن یک فایل خاص User-agent: * Disallow: /private-file.pdf # بلاک کردن تمام URLهای حاوی پارامتر (بسیار مهم برای Crawl Budget) User-agent: * Disallow: /*?

۳. دستور Allow: ایجاد استثنا (مخصوص گوگل)

دستور Allow (که به طور رسمی توسط گوگل پشتیبانی میشود) به شما اجازه میدهد یک قانون Disallow را نقض کنید. این برای سناریوهای پیچیده بهینه سازی robots.txt کاربرد دارد. فرض کنید میخواهید تمام دایرکتوری /wp-content/ را مسدود کنید، اما نیاز دارید که فایلهای CSS و JS درون آن برای رندرینگ صحیح، خزش شوند.

User-agent: Googlebot Disallow: /wp-content/ Allow: /wp-content/uploads/ Allow: /wp-content/themes/theme-name/style.css

۴. استفاده از Wildcards (* و $)

برای بهینه سازی robots.txt به صورت حرفهای، باید از Wildcardها استفاده کنید:

*(ستاره): به معنای «هر توالی از کاراکترها».Disallow: /shop/*.php(هر فایلی در دایرکتوری shop که با .php تمام میشود را بلاک کن).$(دلار): به معنای «پایان URL».Disallow: /*.pdf$(فقط URLهایی را بلاک کن که دقیقاً به.pdfختم میشوند. این کار از بلاک شدن/page?file=report.pdfجلوگیری میکند).

تفاوت حیاتی Disallow و Noindex: خزش در برابر ایندکس

اینجا نقطهای است که بسیاری از متخصصان سئو، حتی افراد باتجربه، دچار اشتباه مرگبار میشوند. درک تفاوت «خزش» و «ایندکس» برای بهینه سازی robots.txt حیاتی است.

۱. دستور Disallow در robots.txt (جلوگیری از خزش)

وقتی شما از Disallow: /page/ استفاده میکنید، به Googlebot میگویید: “اجازه نداری وارد این اتاق شوی.”

نتیجه: گوگلبات هرگز آن صفحه را نمیخزد. چون آن را نمیخزد، هرگز محتوای آن، تگهای متا (مانند noindex) یا تگ کنونیکال آن را *نمیبیند*. اما مشکل اینجاست: اگر آن URL (/page/) از جای دیگری در اینترنت یا سایت شما لینک داشته باشد، گوگل از وجود آن «آگاه» است. در این حالت، گوگل ممکن است خود URL را (بدون دیدن محتوایش) ایندکس کند و در نتایج جستجو با این توضیح نمایش دهد: “No information is available for this page.” (اطلاعاتی برای این صفحه در دسترس نیست) یا “A description for this result is not available because of this site’s robots.txt…”

این یکی از خطاهای Coverage سرچ کنسول است که به “Indexed, though blocked by robots.txt” معروف است.

۲. استراتژی تگ noindex (جلوگیری از ایندکس)

در مقابل، استراتژی تگ noindex (که یک متا تگ در <head> صفحه است) به گوگلبات میگوید: “میتوانی وارد این اتاق شوی و آن را ببینی، اما لطفاً آن را در کتابخانه عمومی (ایندکس) خود قرار نده.”

نتیجه: برای اینکه گوگل بتواند تگ noindex را ببیند، *باید* اجازه داشته باشد صفحه را بخزد. بنابراین، قانون طلایی این است:

قانون طلایی: صفحهای که میخواهید از ایندکس حذف شود (

noindex)، *هرگز* نباید درrobots.txtمسدود (Disallow) شده باشد.

- هدف: حذف کامل صفحه از ایندکس گوگل.

راهحل: از تگmeta name="robots" content="noindex"استفاده کنید و مطمئن شوید آن صفحه درrobots.txtمجاز به خزش (Allow) است.- هدف: صرفهجویی در بودجه خزش (صفحات بیارزش مانند فیلترها).

راهحل: ازDisallowدرrobots.txtاستفاده کنید و بپذیرید که شاید خود URL (بدون محتوا) ایندکس شود.

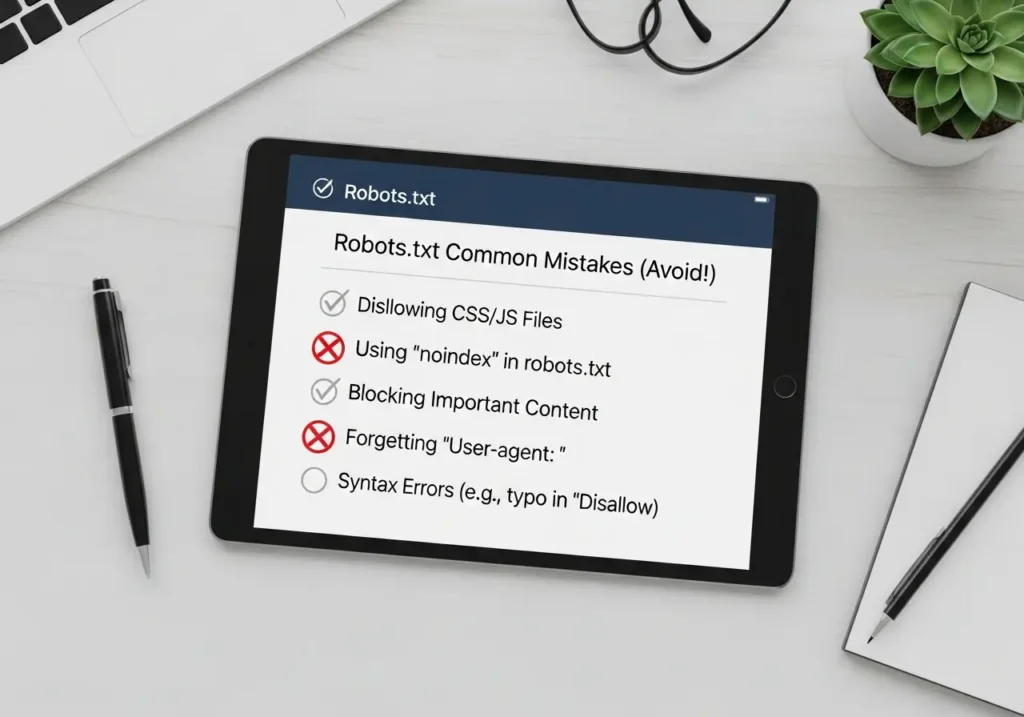

اشتباهات رایج و مرگبار در بهینه سازی robots.txt

یک فایل robots.txt که به اشتباه پیکربندی شده باشد، میتواند آسیب فاجعهباری به سئوی سایت شما بزند. بهینه سازی robots.txt به معنای دوری از این تلههاست.

۱. فاجعه: بلاک کردن کل سایت (Disallow: /)

این اشتباه معمولاً زمانی رخ میدهد که یک سایت از حالت Staging (آزمایشی) به حالت Live (زنده) منتقل میشود و توسعهدهنده فراموش میکند فایل robots.txt موقت را حذف کند.

User-agent: * Disallow: / <-- این دستور به گوگل میگوید "هیچ چیز" را نخزد.

این یک دستور ساده، کل سایت شما را از نتایج جستجو حذف خواهد کرد. بهینه سازی robots.txt یعنی هرگز این دستور را در سایت زنده نداشته باشید.

۲. بلاک کردن فایلهای CSS و JavaScript (مشکل رندرینگ)

در گذشته، بلاک کردن دایرکتوریهایی مانند /js/ یا /css/ رایج بود. امروز، این یک اشتباه مهلک است. گوگل با استفاده از سیستم رندرینگ (مشابه مرورگر کروم) صفحات را بررسی میکند. اگر گوگل نتواند فایلهای CSS و JS را بخزد، صفحه را به صورت شکسته و ناقص میبیند و این سیگنالی از کیفیت پایین است. همیشه اجازه خزش منابع حیاتی رندر را بدهید.

۳. استفاده از دستورات منسوخ شده (Noindex و Crawl-delay)

Noindex در robots.txt: گوگل رسماً اعلام کرده است که از دستور Noindex: در فایل robots.txt پشتیبانی *نمیکند*. اگر از این دستور استفاده میکنید، هیچ تأثیری ندارد. (به بخش تفاوت Disallow و Noindex مراجعه کنید).

Crawl-delay: این دستور توسط گوگلبات نادیده گرفته میشود. اگر میخواهید نرخ خزش گوگل را مدیریت کنید، باید از تنظیمات مربوطه در سرچ کنسول استفاده کنید، نه بهینه سازی robots.txt.

۴. اشتباه در بزرگی و کوچکی حروف (Case-Sensitivity)

مسیرها (Paths) در فایل robots.txt به بزرگی و کوچکی حروف حساس هستند (Case-Sensitive). Disallow: /Page/ با Disallow: /page/ متفاوت است. مطمئن شوید که دقیقاً همان مسیری را که در URLها وجود دارد، مسدود میکنید.

نمونه فایل robots.txt برای وردپرس (یک الگوی بهینه)

robots.txt برای وردپرس یک مثال عالی برای بهینه سازی robots.txt است. وردپرس دایرکتوریهای ادمین و فایلهای هسته زیادی دارد که نیازی به خزش ندارند. یک فایل بهینه شده به این شکل است:

User-agent: * # مسدود کردن بخشهای ادمین و هسته وردپرس Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /readme.html Disallow: /xmlrpc.php # مسدود کردن نتایج جستجوی داخلی و فیدهای تکراری # اینها نمونههای کلاسیک هدر دادن بودجه خزش هستند Disallow: /search/ Disallow: /?s= Disallow: /feed/ Disallow: /comments/feed/ Disallow: /trackback/ # اجازه دادن به فایلهای حیاتی (مانند AJAX برای عملکردها) Allow: /wp-admin/admin-ajax.php # مسدود کردن پلاگینها، اما اجازه دادن به فایلهای استایل و JS آنها # (این بخش نیاز به سفارشیسازی دقیق دارد) Disallow: /wp-content/plugins/ Allow: /wp-content/plugins/*.js Allow: /wp-content/plugins/*.css # اجازه به خزش فایلهای آپلودی Allow: /wp-content/uploads/ # آدرس سایت مپ (بسیار مهم) Sitemap: https://example.com/sitemap_index.xml

تست فایل robots.txt قبل از انتشار

هرگز فایل robots.txt را مستقیماً ویرایش و ذخیره نکنید. همیشه از ابزار تست robots.txt گوگل (Google’s robots.txt Tester) در سرچ کنسول قدیمی یا بخش “Blocked URLs” در ابزار URL Inspection جدید استفاده کنید. تست کنید که آیا URLهای مهم شما (مانند صفحات محصول) به اشتباه مسدود نشده باشند.

نتیجهگیری: robots.txt، دروازهبان استراتژیک Crawl Budget

فایل robots.txt یک ابزار امنیتی نیست، بلکه یک ابزار قدرتمند سئو فنی است. برای «سارا»، به عنوان مدیر بازاریابی فنی، بهینه سازی robots.txt به معنای انتقال از یک رویکرد واکنشی به یک رویکرد استراتژیک برای مدیریت منابع گوگل است.

ماموریت شما در بهینه سازی robots.txt ساده است: با جلوگیری از خزش گوگل در بخشهای بیارزش و تکراری، اطمینان حاصل کنید که Googlebot تمام انرژی و Crawl Budget خود را صرف کشف، خزش و ایندکس کردن محتوایی میکند که واقعاً برای کسبوکار شما اهمیت دارد. برای اطلاعات بیشتر، همیشه به مستندات رسمی گوگل در مورد robots.txt به عنوان منبع نهایی مراجعه کنید.